ETL Pipeline คืออะไร

การมีข้อมูลคุณภาพดี มีความสำคัญมากสำหรับ Data Science Project แต่ข้อมูลมักมาจากหลายแหล่งและอยู่ในรูปแบบที่ไม่เป็นระเบียบ ข้อมูลบางส่วนมาจากฐานข้อมูล ในขณะที่บางส่วนมาจากไฟล์หรือเว็บไซต์ ข้อมูลดิบ (Raw data) เหล่านี้จึงไม่สามารถใช้งานในทันทีได้ จำเป็นต้องมีการทำความสะอาดและจัดระเบียบข้อมูลเสียก่อน

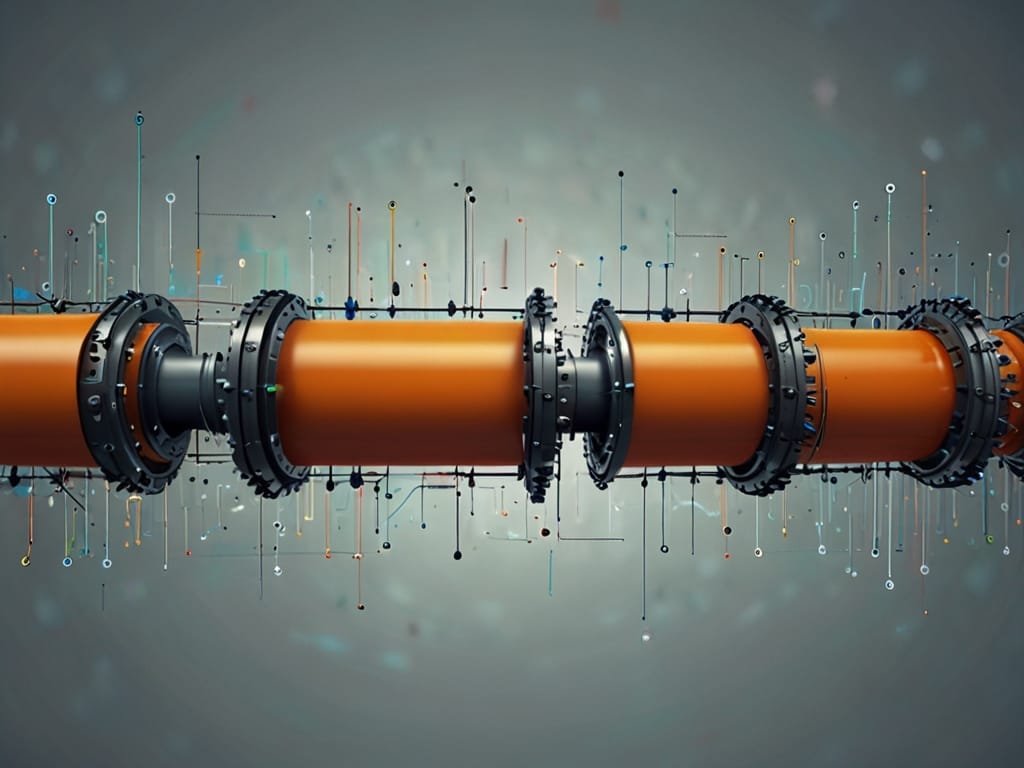

ETL คือ กระบวนการที่ช่วยในเรื่องนี้ ย่อมาจาก Extract, Transform และ Load

- Extract คือ การรวบรวมข้อมูลจากแหล่งต่างๆ

- Transform คือ การทำความสะอาดและจัดรูปแบบข้อมูล

- Load คือ การจัดเก็บข้อมูลในฐานข้อมูลเพื่อให้เข้าถึงได้ง่าย

การสร้าง ETL Pipeline จะทำให้กระบวนการนี้เป็นไปโดยอัตโนมัติ ETL Pipeline ที่มีประสิทธิภาพจะช่วยประหยัดเวลาและข้อมูลมีความน่าเชื่อถือ

ETL Pipeline มีความสำคัญ เพราะเราต้องการสิ่งต่อไปนี้

- คุณภาพข้อมูล (Quality): การแปลงข้อมูลช่วยทำความสะอาดข้อมูลโดยจัดการค่าที่ขาดหายไปและแก้ไขข้อผิดพลาด

- การเข้าถึงข้อมูล (Accessibility): ETL Pipeline นำข้อมูลจากหลายแหล่งมาไว้ในที่เดียวเพื่อให้เข้าถึงได้ง่าย

- การทำงานอัตโนมัติ (Automation): Pipeline ทำให้การทำงานซ้ำๆ เป็นแบบอัตโนมัติและให้ผู้เชี่ยวชาญด้านข้อมูลสามารถมุ่งเน้นไปที่การวิเคราะห์ได้

แนวทางปฏิบัติทสำหรับ ETL Pipeline ที่มีประสิทธิภาพและเชื่อถือได้

- ใช้ Modularity: แยกส่วน Pipeline ออกเป็น Functions ที่เล็กลงและนำกลับมาใช้ใหม่ได้

- การจัดการข้อผิดพลาด: เพิ่มแนวทางในการจัดการข้อผิดพลาดที่อาจะเกิดขึ้นในขั้นตอนต่างๆ Extract, Transform, Load

- เพิ่มประสิทธิภาพการทำงาน (Optimization): เพิ่มประสิทธิภาพการ Search และ การจัดการหน่วยความจำสำหรับข้อมูลขนาดใหญ่

- ทดสอบความเป็นอัตโนมัติ: ทดสอบการ Transform และ Data Format แบบอัตโนมัติเพื่อให้แน่ใจว่าข้อมูลมีความถูกต้อง

ข้อมูลอ้างอิง https://www.kdnuggets.com/developing-robust-etl-pipelines-for-data-science-projects